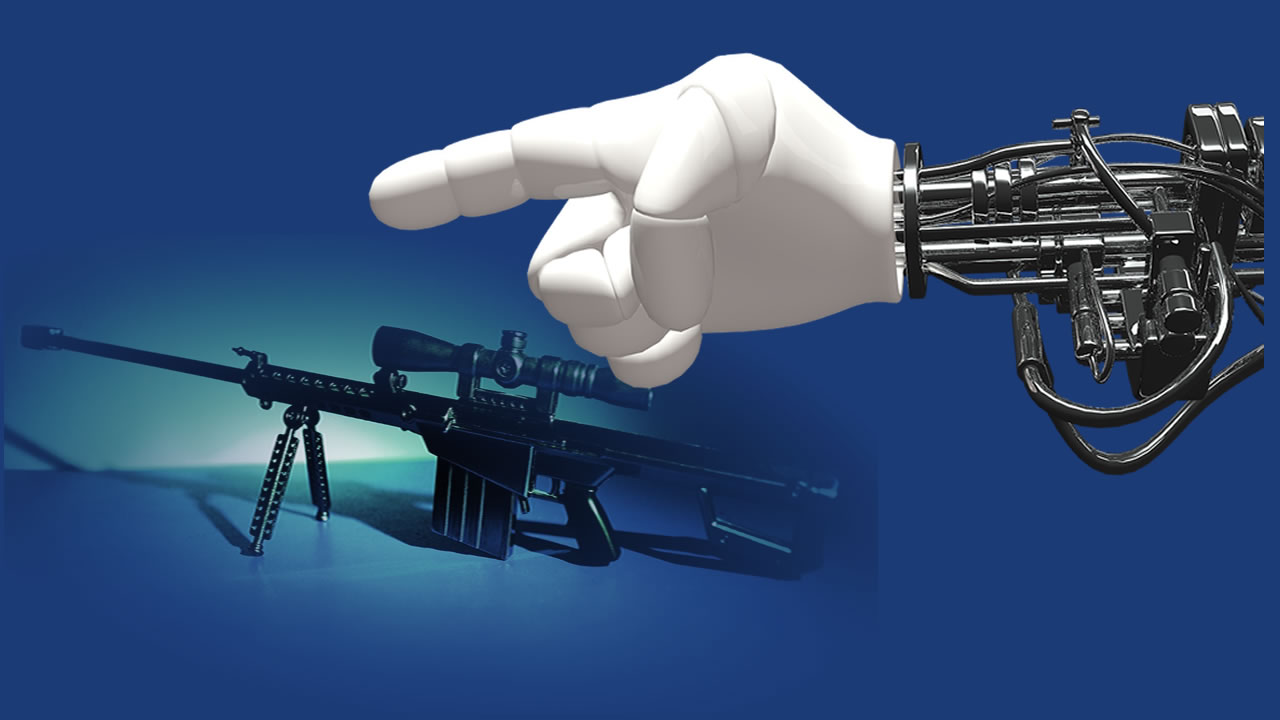

Miles de científicos que se especializan en inteligencia artificial (IA) han declarado que no participarán en el desarrollo o fabricación de robots que puedan identificar y atacar a personas sin supervisión humana.

Demis Hassabis en Google DeepMind y Elon Musk de la compañía estadounidense de cohetes SpaceX se encuentran entre los más de 2.400 firmantes, que pretende disuadir a las empresas militares y las naciones de construir letales sistemas autónomos de armas, también conocidos como «Leyes».

La reciente medida realizada por científicos y organizaciones interesadas en resaltar los peligros de entregar decisiones de vida o muerte a las máquinas mejoradas con IA, sigue a los llamados para una prohibición preventiva de la tecnología que los activistas creen que podría marcar el comienzo de una nueva generación de armas de destrucción masiva.

El compromiso, orquestado por la organización The Future of Life Institute con sede en Boston, hace un llamado a los gobiernos para que acuerden normas, leyes y regulaciones que estigmaticen y proscriban efectivamente el desarrollo de robots asesinos. A falta de tales medidas hoy, los signatarios se comprometen a «ni participar ni apoyar el desarrollo, la fabricación, el comercio o el uso de armas letales autónomas».

Más de 150 empresas y organizaciones relacionadas con IA agregaron sus nombres al compromiso anunciado hoy en la Conferencia Internacional Conjunta sobre IA en Estocolmo.

Yoshua Bengio, un pionero de la IA en el Instituto de Montreal para Algoritmos de Aprendizaje, le dijo al diario The Guardian que si la promesa avergüenza a esas compañías y organizaciones militares que construían armas autónomas, la opinión pública se inclinaría en su contra. «Este enfoque realmente funcionó para las minas terrestres, gracias a los tratados internacionales y la vergüenza pública, a pesar de que los principales países como Estados Unidos no firmaron el tratado que prohíbe las minas terrestres». Las empresas estadounidenses han dejado de construir minas terrestres», dijo. Bengio firmó el compromiso de expresar su «gran preocupación con respecto a las letales armas autónomas».

El ejército es uno de los principales financiadores y adoptantes de la tecnología de inteligencia artificial. Con sistemas informáticos avanzados, los robots pueden volar misiones sobre terreno hostil, navegar en el suelo y patrullar bajo los mares.

Para muchos investigadores, darles a las máquinas la decisión sobre quién vive y muere cruza una línea moral.

«Tenemos que convertir en una norma internacional que las armas autónomas no son aceptables. Un humano siempre debe estar al mando», dijo Toby Walsh, profesor de IA en la Universidad de Nueva Gales del Sur en Sydney, quien firmó el compromiso.

«No podemos evitar que una persona determinada construya armas autónomas, del mismo modo que no podemos evitar que una persona determinada construya un arma química», agregó. «Pero si no queremos que los estados canallas o los terroristas tengan fácil acceso a armas autónomas, debemos asegurarnos de que no sean vendidas abiertamente por las compañías armamentistas».

Los investigadores pueden optar por no trabajar en armas autónomas, pero lo que otros hacen con sus avances publicados está efectivamente fuera de su control.

«Si fuera un investigador de visión artificial que hubiera firmado este compromiso, primero me comprometería a seguir los usos posteriores de mis tecnologías y hablar en contra de su aplicación para automatizar el reconocimiento de objetivos y, en segundo lugar, me niego a participar ya sea asesorando o ayudando directamente para incorporar la tecnología en un sistema autónomo de armas», dijo Lucy Suchman, otra signataria y profesora de antropología de la ciencia y la tecnología en la Universidad de Lancaster.